Levier potentiel de décarbonation, la technologie devrait être mise au service de la transformation durable. À ce titre, l’intelligence artificielle (IA) et notamment l’intelligence artificielle générative (GenAI), peut offrir des opportunités intéressantes en matière de durabilité à condition d’avoir conscience de son impact environnemental et de s’attacher à le réduire à court terme.

L’intelligence artificielle évolue très rapidement. Elle peut apporter des avantages significatifs économiques et sociaux. En améliorant les prévisions, en optimisant les processus et l’affectation des ressources, en surveillant les émissions de gaz à effet de serre ou de nos pollutions… les cas sont nombreux pour lesquels l’IA peut aboutir à des résultats bénéfiques pour la société et l’environnement, et offrir des avantages concurrentiels clés aux entreprises.

Pour autant, toute opportunité présente également des risques. « C’est pourquoi il faut développer l’IA générative en considérant les enjeux du développement durable ». Considération qui fait partie des valeurs cardinales de Salesforce : « nous appliquons à nos technologies, nos exigences en matière de développement durable, tout comme nous prenons en compte nos valeurs fondamentales d’innovation, de confiance et de succès client ». Une approche holistique essentielle à Salesforce, pour qui les entreprises sont de véritables plateformes du changement.

Prendre en compte le cycle de vie entier de l’IA

« Des études récentes ont estimé que l’entraînement des modèles de GenAI GPT-3 ou Llama 2 a émis 550 tonnes de carbone chacun. Et il ne s’agit que de la face émergée de l’iceberg car la consommation d’électricité, le déploiement des solutions, l’expérimentation et l’équipement informatique ne sont pas pris en compte dans ces estimations », précise Sasha Luccioni, Climate Lead au sein de Hugging Face, start-up franco-américaine spécialisée dans le domaine de l’IA.

L’analyse du cycle de vie (ACV) peut offrir une réponse pertinente pour avoir une vision élargie de l’impact environnemental de l’intelligence artificielle. Extraction des matériaux, fabrication des composants et des équipements, logistique, énergie et ressources consommées pour entraîner les Large Language Models (LLM) sont autant de variables à considérer.

Les principes de l’IA responsable de Salesforce

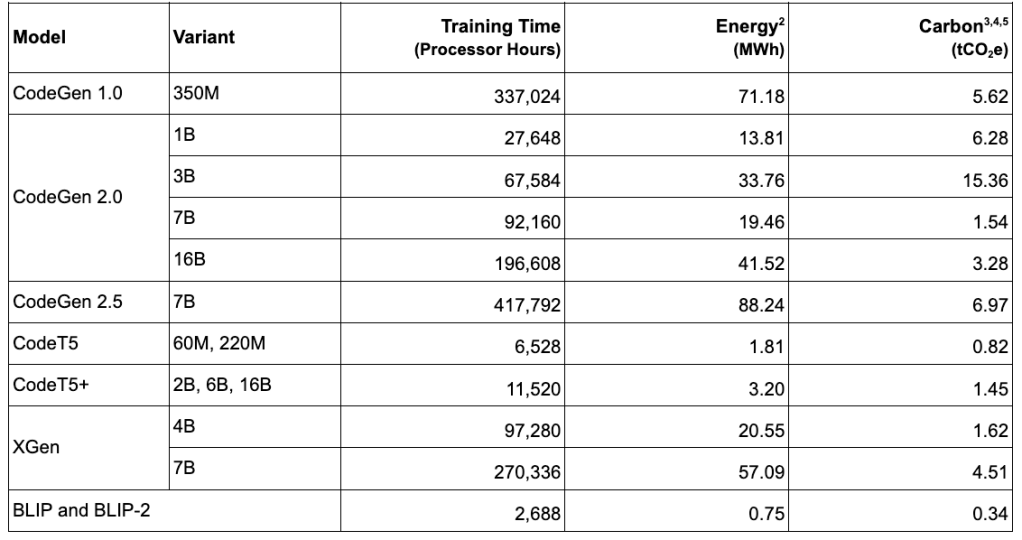

L’équipe AI Research de Salesforce privilégie les modèles de taille adéquate, plus faciles à perfectionner et plus rapides, à l’instar de CodeGen, qui traduit des commandes en langage Python. Développée par AI Research, sa version 2.5 utilise moins de variables que les précédentes, tout en délivrant des résultats identiques, ce qui garantit son efficacité tout en diminuant sa consommation d’énergie.

Des principes de conception pour une IA durable résumés en quatre piliers.

1. Optimisation des modèles

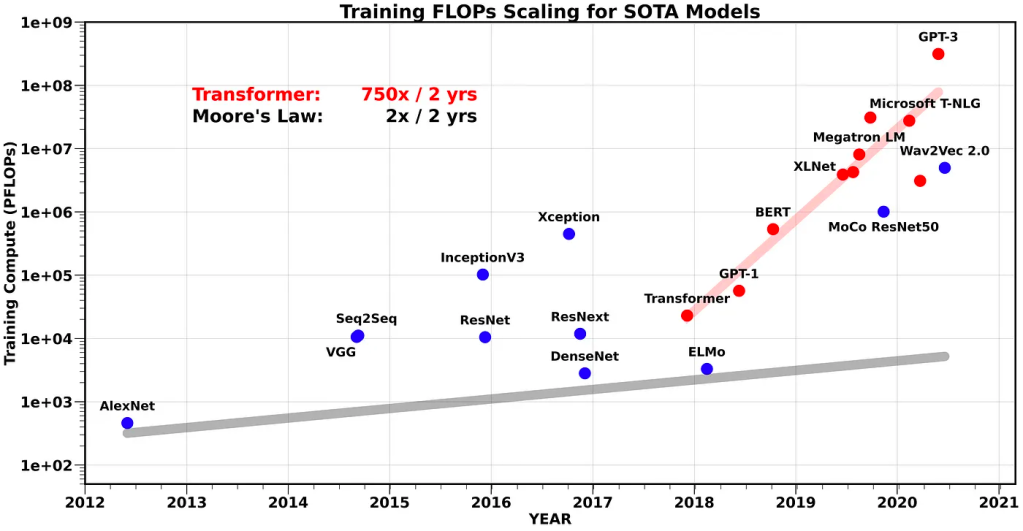

L’énergie nécessaire à l’entraînement d’un modèle dépend du nombre de ses paramètres et de la taille des données d’entraînement. Ces dernières années, la tendance a été d’augmenter considérablement ces deux facteurs, ce qui a entraîné une croissance exponentielle (multiplication par 750 tous les 2 ans) des besoins énergétiques des transformateurs, l’architecture LLM de référence. En fait, cette tendance semble éclipser la loi de Moore , suggérant que les améliorations de l’efficacité matérielle à elles seules ne suffiront pas à répondre à la demande croissante de calcul.

La quantité de calcul nécessaire pour former différents modèles par rapport à la loi de Moore. Source : Amir Gholami

Bien que la tendance soit aux modèles de grande taille et polyvalents, Salesforce AI Research reste concentré sur le développement de modèles spécifiques à un domaine, personnalisés en fonction de leurs applications prévues.

Par exemple, le modèle CodeGen de l’équipe Salesforce, initialement publié en 2022, a été l’un des premiers LLM à permettre aux utilisateurs de « traduire » un langage naturel en langages de programmation, comme Python.

La dernière version – CodeGen 2.5 – a été optimisée pour l’efficacité grâce à une formation multi-époques et à l’attention flash . Le résultat est un modèle qui fonctionne aussi bien que des modèles plus grands à moins de la moitié de la taille .

En plus d’être plus durables, l’équipe a appris que les modèles plus petits sont plus rentables, plus faciles à optimiser et fonctionnent plus rapidement, améliorant ainsi l’expérience utilisateur.

2. Choix du matériel pour entraîner et déployer l’IA

Une fois le modèle optimisé, il faut choisir le hardware pour former et déployer une IA. Les fabricants de matériel d’IA dévoilent fréquemment de nouvelles versions avec des améliorations d’efficacité substantielles. Le matériel d’IA de Google, le Tensor Processor Unit (TPU) , est devenu plus efficace à chaque nouvelle génération, et Salesforce AI Research a exploité ces avancées.

Google estime que le nouveau TPU v4 est 2,7 fois plus efficace que le TPU v3et les calculs de l’équipe ont confirmé cette affirmation, notant une augmentation de l’efficacité de 2,8 fois (mesurée en faisant la moyenne des paramètres du modèle par énergie d’entraînement consommée). De plus, nos premiers tests ont révélé que le tout nouveau « TPU v5p surpasse jusqu’à 2 fois la génération précédente de TPU v4 ».

Ces gains d’efficacité devraient se poursuivre. Nvidia affirme par exemple que ses prochains GPU H200 atteindront des performances 18 fois supérieures à celles des GPU A100, largement utilisés aujourd’hui.

Au-delà du matériel GPU/TPU spécialisé pour l’IA, des progrès ont également été réalisés dans le déploiement de l’IA sur des processeurs plus traditionnels, présents sur les ordinateurs grand public. CodeGen 2.5 peut être déployé localement dès aujourd’hui, ce qui permet de réduire la consommation d’énergie, d’augmenter la vitesse, de renforcer la sécurité et d’améliorer la personnalisation.

3. Priorité aux centres de données à faible émission de carbone

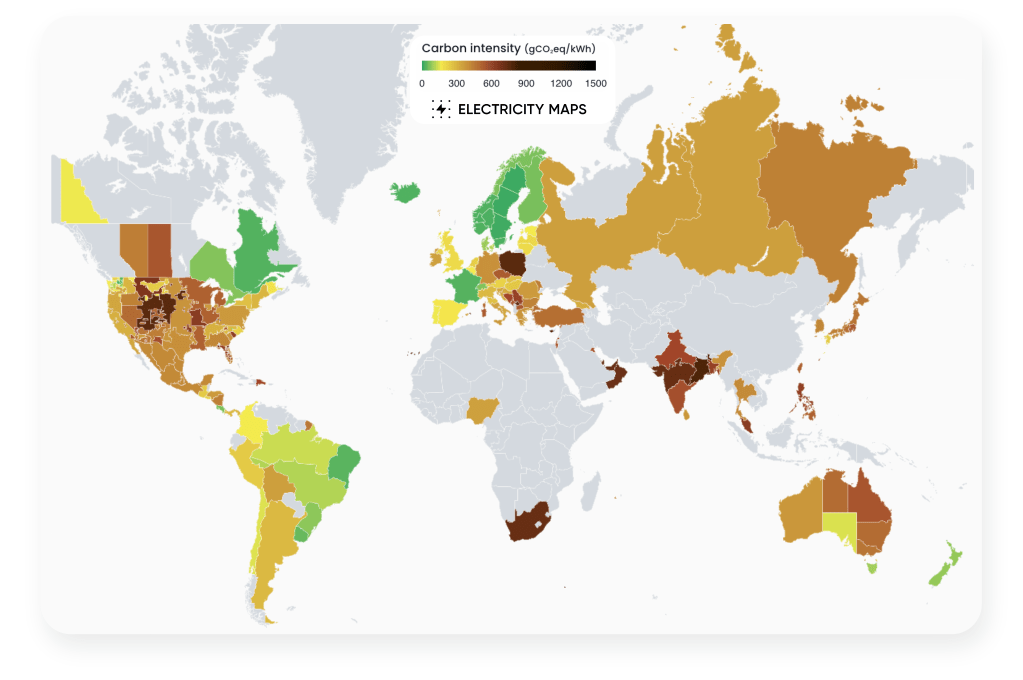

Les émissions des centres de données varient considérablement car ils sont alimentés par les réseaux électriques locaux. En fonction de la dépendance des réseaux aux combustibles fossiles, leur intensité carbone peut varier considérablement d’une région à l’autre (voir graphique ci-dessous).

L’intensité carbone variable des réseaux électriques mondiaux (source : electricitymaps.com )

Dans cette optique, il est important de savoir quels centres de données sont utilisés pour former et déployer l’IA.

Pour réduire les émissions de notre modèle d’IA, Salesforce a formé ses modèles dans des centres de données à faible intensité de carbone, alimentés par une électricité qui émet 68,8 % de carbone de moins que la moyenne mondiale de l’électricité. Cela a permis d’ économiser 105 tonnes d’équivalent dioxyde de carbone (tCO2e) par rapport à l’utilisation de centres de données ayant une intensité carbone moyenne mondiale pour la formation. .

2. Au-delà du développement de modèles d’IA : les techniques d’IA durables

L’approche de l’équipe en matière de durabilité de l’IA ne s’arrête pas au développement et au déploiement des modèles.

Comme pour tous les produits de Salesforce, AI Research veillent à ce que ses modèles soient conçus dans une optique de durabilité, de l’architecture à l’interface utilisateur. Par exemple, lorsque plusieurs modèles d’IA sont disponibles, nous choisissons par défaut l’option la plus efficace et la plus appropriée pour chaque cas d’utilisation.

De plus, les techniques d’ingénierie rapides intégrées à la fonctionnalité Prompt Builder — qui permet la conception de modèles de prompts plus personnalisés et enrichis — dispose d’une mise en cache. En mettant en cache les invites et les sorties pour stocker et réutiliser les réponses aux requêtes courantes, l’équipe réduit considérablement les calculs répétitifs, accélérant ainsi les temps de réponse et la consommation d’énergie. L’expérience utilisateur n’en est que plus améliorée.

L’équipe AI Research intègre également des mécanismes tels que le suivi de l’utilisation et les limites de débit dans sa plateforme Einstein 1 basée sur Hyperforce , favorisant une utilisation consciente, responsable et sécurisée de nos systèmes d’IA.

Mesure et Transparence de l’impact

L’intégration de ces stratégies dans l’approche de développement de l’équipe de recherche en IA a permis de créer des modèles d’IA à empreinte carbone nettement plus faible. Pour comprendre ces impacts, l’équipe a calculé la consommation d’énergie et de carbone de la préformation du modèle, qui est de loin l’étape du cycle de vie du modèle d’IA la plus impactante :

Impacts environnementaux de la préformation du modèle d’IA Salesforce

Au total, la pré-formation de ces modèles a permis d’obtenir 48 tCO2 e : 11 fois moins que les émissions de GPT-3. Au-delà de la phase de formation, l’impact de l’utilisation continue de nos modèles a été révélé dans les classements Hugging Face et ML.Energy.

L’équipe estime que la transparence est la clé d’ une IA fiable et reste déterminée à partager ses impacts environnementaux et les leçons apprises, et enjoint d’autres acteurs de l’écosystème de l’IA à suivre son exemple. Pour suivre notre progression, vous pouvez consulter les mises à jour d’AI Research et explorer les modèles sur Hugging Face et GitHub.

3. Mettre la technologie au service d’actions environnementales

L’engagement de Salesforce en matière de développement durable ne se limite pas à la réduction de l’impact, il s’agit également de tirer parti de l’IA pour créer des avantages environnementaux tangibles. Les innovations en matière d’IA améliorent les rapports ESG au sein de notre Net Zero Cloud , illustrant l’intersection croissante entre la technologie et la durabilité des entreprises. CodeGen, qui alimente Einstein for Developers et Einstein for Flow, améliore l’efficacité du code, avec des recherches tierces indiquant une amélioration de 2,5 fois . Cette efficacité améliorée s’étend également aux clients de Salesforce, avec des outils basés sur l’IA qui leur permettent d’analyser et de réduire automatiquement les émissions de carbone de leur code Apex.

L’environnement est également un domaine d’intérêt majeur pour l’équipe de recherche en IA. Elle est pionnière dans le domaine de l’IA pour la coopération climatique mondiale , en utilisant l’IA pour élaborer des protocoles de négociation et des accords climatiques qui pourraient façonner les futures politiques environnementales.

De plus, son modèle de langage ProGen AI, conçu pour générer de nouvelles protéines artificielles, fait des progrès dans le développement de matériaux compostables à partir d’amidon de carotte.

Un autre projet notable est SharkEye , qui utilise l’IA pour détecter les grands requins blancs, contribuant ainsi à une base de données vitale pour les scientifiques, les écologistes et les communautés locales.

En savoir plus

- Consultez ce blog pour en savoir plus sur la manière dont Salesforce développe l’IA de manière responsable.

- Restez connecté — rejoignez notre communauté de talents !

- Consultez nos équipes Technologie et Produits pour savoir comment vous pouvez vous impliquer.

1 Salesforce a formé ses modèles dans des centres de données dont les émissions de carbone étaient inférieures de 68,8 % à l’intensité carbone moyenne mondiale de l’électricité. Le facteur carbone agrégé pondéré avant formation du modèle Salesforce est de 136 gCO2e/kWh. La réduction de 68,8 % et l’évitement de 105 tCO2e sont comparés à la moyenne mondiale de 436 gCO2e/kWh ( source ).

2 L’énergie est calculée en multipliant le temps de formation, le TDP du processeur (utilisé pour une hypothèse prudente, fourni par le fabricant du processeur) et le PUE du centre de données (fourni par le propriétaire du centre de données).

3 Le carbone est calculé en multipliant l’énergie par l’intensité carbone du réseau électrique (fournie par le propriétaire du centre de données).

4 Émissions de carbone dues uniquement à l’électricité. Bien que les données sur le carbone incorporé ne soient pas actuellement fournies par les fabricants, nous espérons étendre la portée du calcul à l’avenir.

5 Grâce à une combinaison d’approvisionnement en énergie renouvelable et de crédits carbone de haute qualité, toutes les émissions résiduelles sont entièrement compensées par Salesforce et/ou nos fournisseurs.