כנראה שאין אדם בישראל שלא שמע במהלך השנה שחלפה את צמד המילים ChatGPT, וסביר להניח שכל מי ששמע את צמד המילים האלו, יודע שכיום ניתן לייצר באמצעות בינה מלאכותית אינספור סוגי תוכן. כל זאת בזכות העובדה שהמודלים של הבינה המלאכותית אומנו להבין את השפה האנושית – ולהחזיר תשובה בהתאם. אפשר לבקש מהכלים האלו לכתוב עבורנו קטע קוד בכל שפת תכנות, לבנות מצגת מכירתית, לכתוב מיילים ועוד. וכל זה נכון רק לינואר 2024…

הזדמנויות מדהימות – וגם סיכונים משמעותיים

הכל מתחיל בסוף נובמבר 2022, כשחברת open ai משחררת את הגרסה הראשונה של ChatGPT, ומאז העולם הטכנולוגי כבר לא נראה אותו הדבר. "השילוב של כמויות עצומות של מידע יחד עם יכולות חדשות של בינה מלאכותית המאפשרות לייצר מהמידע הזה תוכן מותאם אישית, מסמן את תחילת מהפכת הדאטה והבינה המלאכותית", אומר אסף עשני, Distinguished, Account SE בסיילספורס. "השימוש בטכנולוגיות בינה מלאכותית מתקדמות, במיוחד מודלים כמו LLM, והסיכונים שעסקים עלולים להתמודד איתם אם הם לא יתנו עדיפות לשימוש בטוח ואחראי בכלים האלו – הוא נושא מכריע שהופך ליותר ויותר רלוונטי בעולם העסקים".

לדבריו, בעולם שבו הבינה המלאכותית מתקדמת במהירות, נוצרות הזדמנויות מדהימות, אך גם אתגרים משמעותיים. שילוב של יכולות GPT במוקדי שירות ומכירה של ארגונים – בין אם קטנים או גדולים – יאפשר לארגונים אלו להפוך להיות יעילים יותר וממוקדים יותר מבחינת השירות הפרסונלי שהם יוכלו להציע ללקוחות שלהם.

בעוד ש-GPT טומן בחובו פוטנציאל עצום לשינוי תעשיות וייעול תהליכים שונים, הוא אינו חף מסיכונים, במיוחד עבור עסקים שלא מצליחים להשתמש בו בבטחה, וקיים ספק האם הארגונים האלו מודעים לסכנות הללו. מספיק אפילו להפנות את השאלה ל-ChatGPT והוא יפרוס בפנינו לא מעט סיכונים בשימוש לא נכון ביכולות הללו:

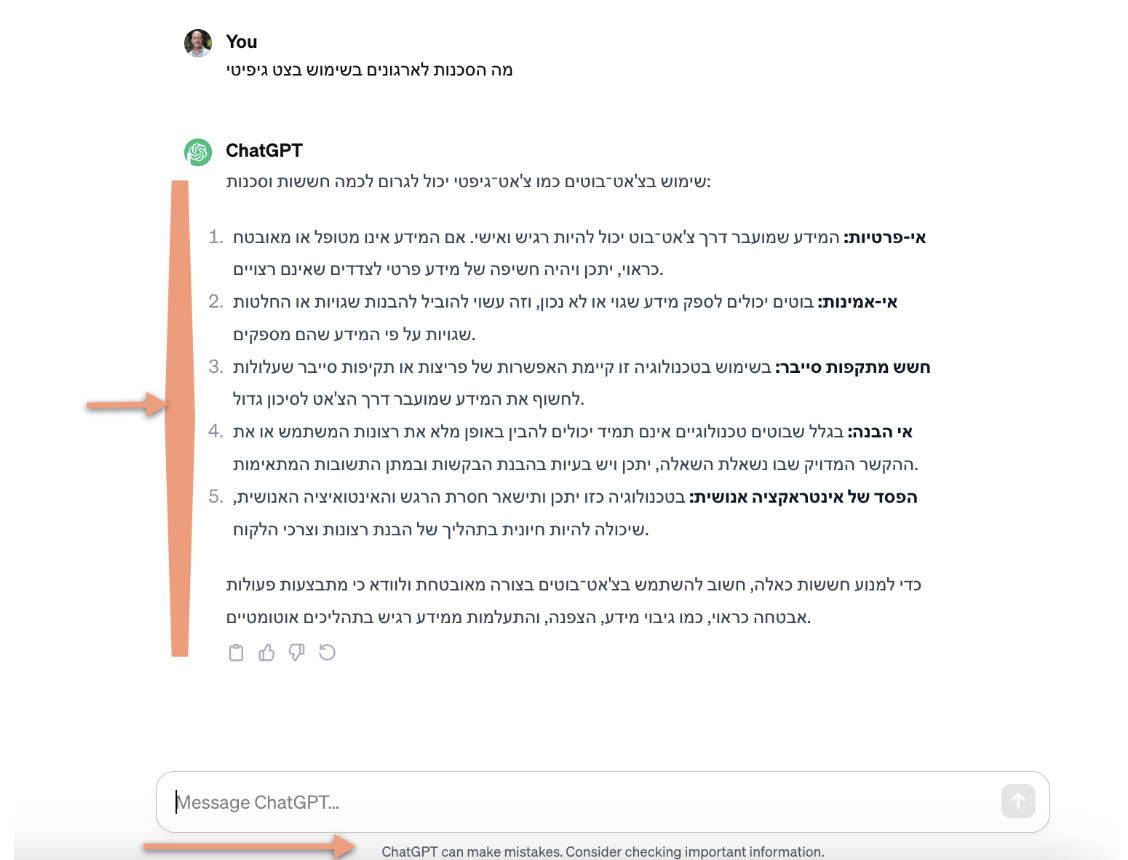

בסיילספורס, אנחנו מבינים שחוויות לקוח מבוססות יכולות בינה מלאכותית הן היעד של הלקוחות שלנו, אבל הסכנות שטמונות בשימוש לא נכון ביכולות הללו, יכולות להוות מחסום כניסה עבורם לתחום הזה וכרגע קיים פער באמון שניתן לתת ביכולות ה-GPT.

מתוכן בלתי הולם ועד אפליה ופרטיות

אחד הנושאים הקריטיים בהקשר זה הוא התוכן הבלתי הולם. ה-GPT לומד ומשכלל את עצמו על בסיס מגוון רחב של נתונים באינטרנט – מה שמהווה פוטנציאל ליצירת תוכן שעלול להיות לא ראוי או פוגעני. מספיק לדמיין תרחיש שבו עסק משתמש ב-GPT לאינטראקציות עם לקוחות, והמודל מייצר תגובות הנוגדות את ערכי החברה או שהוא מאיר פלח מסוים מבסיס הלקוחות שלהם באור שלילי. הדבר עלול להוביל לפגיעה במוניטין של העסק, לחוסר שביעות רצון של לקוחות ואפילו להשלכות משפטיות.

לדברי אסף, סיכון קריטי נוסף הוא הנוכחות של הטיה והגינות בתכנים שנוצרו על ידי GPT. "המודלים האלה לומדים מכמויות אדירות של נתונים, ואם אותם נתונים מכילים הטיות, המודל עשוי לשכפל ולהגביר אותן. עבור עסקים, זה מתורגם לפוטנציאל לתוצאות מפלות".

איך למשל? "תאר לעצמך שימוש ב-GPT בתהליכי גיוס עובדים או בשירות לקוחות – והמודל מנציח בלי כוונה הטיות מגדריות, גזעיות או אחרות".

ומה בנוגע לאבטחת מידע ופרטיות? "אבטחת מידע ופרטיות הם גם גורמים משמעותיים שעסקים חייבים לקחת בחשבון בכל אזור שבהם הם שוקלים לשלב את יכולת ה-GPT. בכל אינטראקציה מול ה-GPT שבה ארגון ירצה לקבל תוכן מותאם אישית ללקוח שפונה, יש צורך לתת את הדעת איך להעביר את המידע של הלקוח ל-GPT מבלי לפגוע בפרטיות של הלקוח ומבלי לאפשר ל-GPT ללמוד ולהשתפר לפעמים הבאות על בסיס ה-prompt שהועבר לו. המודל בנוי בצורה כזו שהוא לומד ומתקן את עצמו. וכך, עלול להיווצר מצב שהתשובות שנוצרות חושפות יותר מהמתוכנן, דבר שעלול להוות איום על אבטחת המידע והפרטיות של הלקוחות. הגנה על נתונים רגישים ונתוני הלקוח צריכה להיות בראש סדר העדיפויות של כל ארגון אשר שוקל להכניס שימוש ב-GPT".

קחו בחשבון את הרגולציה

בהקשר של בינה מלאכותית, אי אפשר גם להתעלם מהצורך החשוב לעמוד בתנאי הרגולציה שקיימים במגוון רחב של תעשיות. מעניין לדעת שבאפריל 2023, איטליה הפכה למדינה המערבית הראשונה שהרגלוטור בה אוסר את השימוש ב-ChatGPT, וזאת בגלל שלטענתו אין בסיס משפטי לאיסוף נתונים שהבינה המלאכותית מבצעת על מנת לאמן וללמד את עצמה.

נכון להיום, הרגולציה סביב פיתוח ושימוש במודלים של בינה מלאכותית גנרטיבית רק מתחילה להתגבש. בחודשים האחרונים אנחנו עדים לתחילת תהליך אסדרה רגולטורית של שימוש נכון ב- GPT – בין אם זה דרך האיחוד האירופאי, ארגון ה-G7 או ממשלת ישראל. לכן, עסקים ששוקלים לעשות שימוש ב-GPT חייבים לקחת בחשבון שבטווח הקצר הרגולטור עלול להוציא הנחיות חדשות שיהיו בניגוד לאופן שבו הארגונים בחרו לעשות שימוש ב-GPT, ואי עמידה בהנחיות הללו עלול לגרום להשלכות משפטיות, קנסות ופגיעה במעמדו של העסק בענף שבו הוא פועל.

שכבת ההגנה של סיילספורס

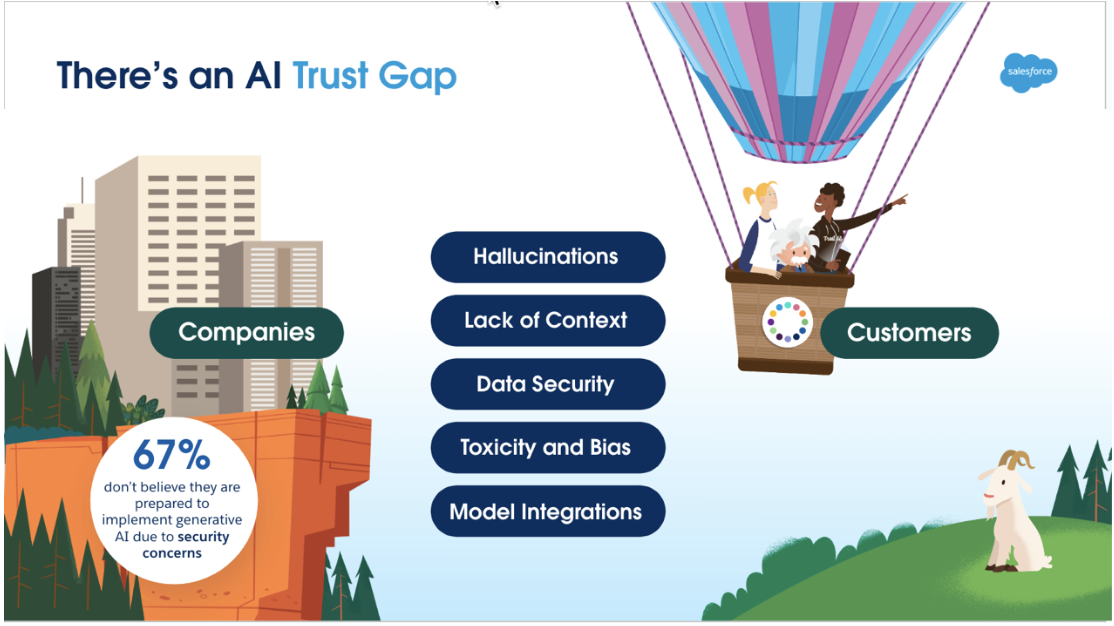

מה עושה סיילספורס כדי להתמודד עם אתגרים והסכנות ששימוש לא מושכל ב-GPT עלול לייצר עבור ארגונים שונים? "כחלק מהמסע שסיילספורס יצאה אליו כדי להכניס יכולות של GPT בכל אחד מהפתרונות שלנו, שמנו לעצמנו כמטרה ראשונה לבנות שכבה שתתן מענה לאותן סכנות הטמונות בשימוש לא אחראי בכלי זה. שכבת האיינשטיין Trust מורכבת מהתכונות, הפונקציונליות, המדיניות והתהליכים שצריך כדי לייצר אמון ובטחון בלקוחות, בכל היבט של חווית הבינה המלאכותית היוצרת של סיילספורס. במסגרת שכבה זו, סיילספורס תיתן מענה לאותן סכנות שקיימות בשימוש ב-GPT".

תוכל לתאר בקצרה את המרכיבים המרכזיים של אותה שכבה? "ראשית, אנחנו עובדים עם כל ספקי ה-LLM כדוגמת חברת open ai, כדי להבטיח ששום מידע שעובר משכבת ה-trust אל ה-GPT לא יישמר ולא ייעשה בו שימוש כדי לשפר את היכולות של GPT. שום מידע לא נשמר מחוץ לסיילספורס והמידע הזה לא נגיש לאף אחד".

"שנית, בתהליך בניית ה-prompt, אותה שאלה שרוצים להעביר ל-GPT, אנחנו רוצים לוודא שכל מידע שצריך לשלוף כדי לשתול אותו ב-prompt יישלף בצורה מאובטחת, מידע רגיש שקשור ללקוח או לארגון יעבור ערבול, ושה-prompt יכיל מידע קונטקסטואלי ורלוונטי כדוגמת מאמרי ידע שישמשו לבניית התשובה״.

"לבסוף, כאשר ה-GPT מחזיר תשובה, אנחנו צריכים לוודא שהיא נעדרת תוכן פוגעני ושכל הערבולים על מידע פרטי ועסקי הוסרו. כמו כן, אנחנו צריכים לשמור בלוגים פנימיים את תהליך בניית ה-prompt והתשובה כדי שישמש לצורכי דיווח רגולטוריים ולמידה פנים ארגונית של יעילות השימוש בכלי הבינה המלאכותית".

ניתן לסכם ולומר שבעוד שהפוטנציאל של GPT וטכנולוגיות בינה מלאכותית דומות הוא עצום, חיוני לעסקים לגשת לשימוש בהם בזהירות ובאחריות. הסיכונים של תוכן לא הולם, הטיה, הפרות אבטחה, אובדן שליטה, תקשורת שגויה ואי ציות לרגולציה הם אמיתיים – ועשויות להיות להם השלכות מרחיקות לכת. כאשר עסקים מאמצים את כוחה של הבינה המלאכותית, עליהם לתעדף שיקולים אתיים בו-זמנית, ליישם מנגנוני ניטור חזקים ולהבטיח שהשימוש ב-GPT תואם את הערכים והמטרות שלהם.

"בסיילספורס אנחנו מאמינים ששכבת ה Trust שבנינו, תיתן מענה לכל אותם סיכונים כדי לאפשר לארגונים לצעוד בבטחה לעולם ה-GPT", מסכם אסף. "זה הזמן לפעול לקראת עתיד שבו בינה מלאכותית משפרת את העסקים של כולנו בצורה אחראית ואתית".

![Agents will change everything about how we work. It's critical to separate fact from fiction. [Adobe Stock | Cream Creative]](https://www.salesforce.com/il/blog/wp-content/uploads/sites/16/2024/12/5-Myths-About-AI-Agents-2160x1215-1.webp?w=150&h=150&crop=1&quality=75)