※本記事は、2023年12月14日に米国で公開された How Five Years of Tech Ethics Will Inform the Era of AI の抄訳です。本資料の正式言語は英語であり、その内容および解釈については英語が優先されます。

生成AIの爆発的な普及は個人や企業を魅了しており、Salesforceを含めてすでに私たちの生活や働き方を変えつつあります。

2023年、生成AIの持つ可能性と危険性によって、「テクノロジーの倫理」は熱気を帯びる一方、当惑も隠せないかたちで脚光を浴びています。殺人ロボットからバイアス、ハルシネーションに至るまで、かつては風変わりで専門的と考えられていたトピックが、AIをめぐる主要な議論の一部となってきました。

私は、必ずしもAIにまつわるすべての誇大広告や過熱に同意しているわけではありませんが、AIの変革の可能性を信じると同時に、「信頼」がテクノロジーそのものと同様にAIに関する話題の中心になっているのを見て、勇気づけられています。そして、この最も刺激的なイノベーションの倫理的な意味合いについて考え、未来のAIの安全性と信頼性を確保するために、今、一歩を踏み出す人が増えていることを心強く感じています。

この最も刺激的なイノベーションの倫理的な意味合いについて考え、未来のAIの安全性と信頼性を確保するために、今、一歩を踏み出す人が増えていることを心強く感じています。

Salesforce 倫理的および人道的利用最高責任者、ポーラ・ゴールドマン(Paula Goldman)

Salesforceの倫理的および人道的利用オフィス(Office of Humane and Ethical Use)が設立5周年を迎えるにあたって、私たちのチームが企業における責任あるテクノロジーのあり方を模索してきたこと、そしてAIの時代に向けて再びそれを実践していることを誇りに思います。ここでは、同オフィスの最初の5年間を振り返り、私たちの今後の重点分野について紹介します。

倫理的テクノロジーの運用

5年前、「テクノロジーの倫理」は決して主流ではありませんでした。議論のテーブルにあがることすらありませんでした。

企業のテクノロジー利用をめぐっては、疑問や論争が生まれ始めていました。しかし、業界として、それらに対処するための確立されたメカニズムや議論はありませんでした。Salesforceの会長 兼 最高経営責任者であるマーク・ベニオフ(Marc Benioff)は、このギャップが生まれつつあることを察知し、顧客やコミュニティとの信頼関係を構築し続けるために行動する必要があると考えました。2018年8月、彼はSalesforceの倫理的および人道的利用オフィスについて発表し、全社的にテクノロジーを倫理的に利用する枠組みを構築するために私を採用しました。

同オフィスは、この種のものとしては企業で初めて設置され、ロードマップはありませんでした。しかし、私たちは目的達成のためには透明性と信頼をもってリードする必要があることを理解していました。

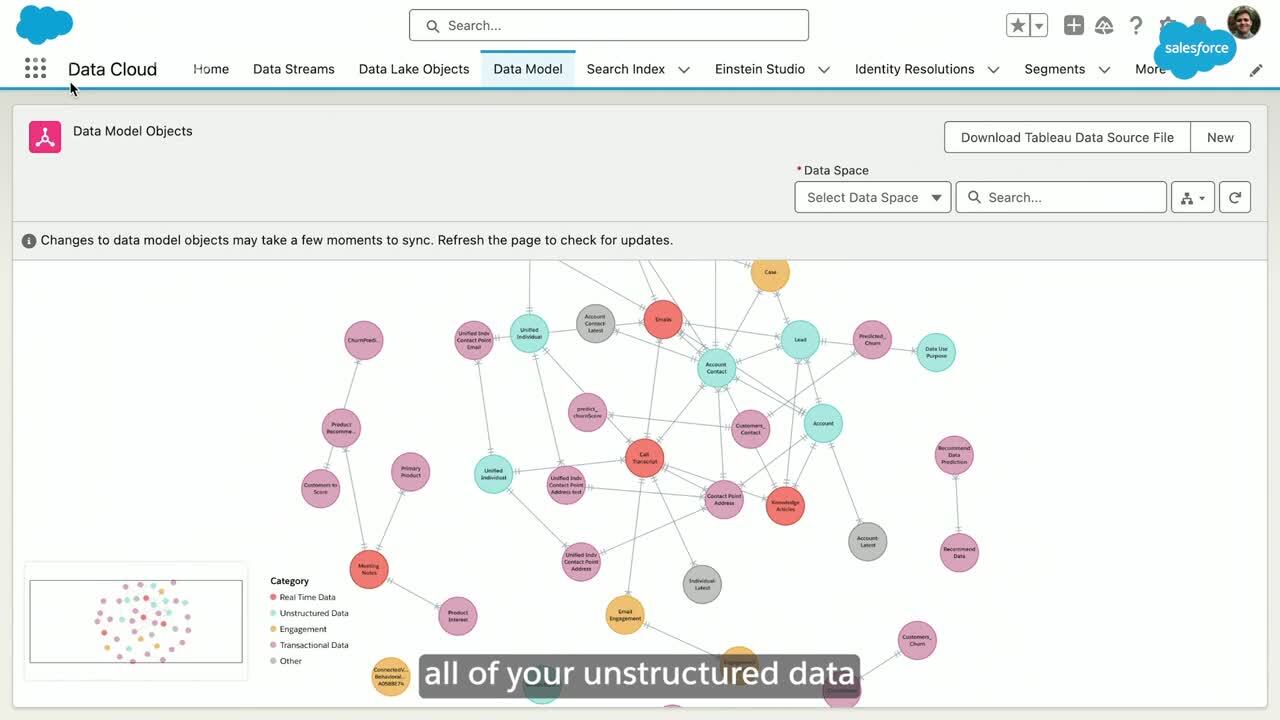

製品チームがAIのリスクを理解し、軽減できるよう、ガイドラインとして「信頼されるAIの原則」を策定しました。また、AIの利用規定(AUP:Acceptable Use Policy)の新しいガードレールや、倫理的に複雑な問題を理解し検討するための倫理的利用諮問委員会といった、ビジネス全体を通してこれらの業務を導くためのポリシーやプロセスを立ち上げました。

AIのイノベーションサイクルの進路を決める

長年にわたり、私たちのオフィスは多くを学び、成長してきました。そして、業界や社会における最も重要な瞬間のいくつかにおいて、Salesforceを導く手助けをしてきました。特にAIは、チームにとって非常に重要なテーマであり続けています。私たちはまだAI革命の初期段階にいますが、私たちのオフィスはすでにAIイノベーションの2つの異なる時代を見てきましたし、その道案内をしてきました。

AI 1.0:予測型AI

AI 1.0は、予測型AIの出現により、商業的な文脈において中心的な役割を果たしました。私たちのオフィスにとっては、歴史上最もダイナミックな時期のひとつであるこの時期に、初めてAIの意味を検証することになったと言えます。データセキュリティやバイアスに関する懸念といったAIのリスクは、新型コロナウイルスの大流行や人種的公正を求める運動を背景に、新たな意味を持つようになりました。私たちのオフィスは、AIが可能にするパーソナライゼーションの進歩がプライバシーを犠牲にすること、あるいはさらに悪いことにバイアスを悪化させることがないよう注意を払いました。

この頃、信頼できるAI、データ倫理、包括的なテクノロジーは、私たちのチームにとって大きな焦点となっていました。私たちは、倫理的なパーソナライゼーションに関わるアプリ内機能とデータプライバシーに関するガイドラインとを作成し、AIが適切なデータに基づいたものであることを保証するためのセーフガード(安全措置)を製品に組み込みました。また、パンデミック対応のための責任ある技術設計、エンドユーザーの多様性を考慮した製品内の包括的なデータモデルの確保、AI製品が顔認証に使用されないような保護措置も講じました。

AI 2.0:生成AI

AI 2.0は2022年末、生成AIの台頭によって商業的に爆発的に普及しました。GPTツールのスピードと精巧さは世界を魅了しましたが、同時に高度なAIのリスクに対する多くの不安も生み出しました。過去一年間のAIに関する議論は、テクノロジーについて楽観的でAIイノベーションを加速させようとする人々と、短期的なものから現実的なものまでさまざまなリスクを警戒する批評家に分かれ、両極化しています。

World Tour New York最大のニュース

私たちのオフィスは、この急速に進化するテクノロジーと歩調を合わせ、これらの新しいイノベーションを安心して採用するために必要なガイドラインやガードレールをお客様に提供し、信頼を確保するよう努めてきました。今年、私たちは「信頼されるAIの原則」を更新し、組織が安全にAIを構築・導入できるよう、「責任ある生成AI開発のための5つのガイドライン」を作成しました。また、医療や法律に関するアドバイスなど、リスクの高い意思決定に関する適切な保護措置や制限の確保など、新たな保護を盛り込んだ初のAI利用規定(AI Acceptable Use Policy)を作成しました。

2024年のSalesforceの倫理的AIの優先事項トップ3

現在はAI革命の初期段階ですが、今後さらに多くの段階を経るであろうことが分かっています。そして、それぞれのイノベーションサイクルには独自の課題が伴うでしょう。AIの時代が続くなか、2024年に倫理的AIを発展させるために私のチームが注力している3つの分野を紹介します:

- 人間による舵取り:AIの導入は、人々がAIを信頼するかどうかにかかっています。私たちは、自動化が信じられないほどの効率性を引き出すことができることを知っていますが、人間の判断が必要なケースも常に存在します。人々が何を信頼すべきか知り、理解し、見直すべきタイミングを理解できるようなAIを構築することが、重要となります。

- リスクベースの規制:信頼できるAI構築のために、各国政府が明確な行動を取り始めているのを見て、勇気づけられています。米国のAIの安全性に関する大統領令から先週のEUのAI法に至るまで、各国政府は当面の問題に対処し、将来のより高度なシステムのための枠組みの整備が可能であることを示しています。規制への気運が高まるなか、システムとモデルを区別するリスクベースの枠組みを受け入れ、イノベーションを奨励し続けることが重要です。

- 取締役会のガバナンス:イノベーションのスピードと規模は、かつてないほどAIを取締役会の場に登場させています。企業がAIを作るにせよ、使うにせよ、取締役会のメンバーがAIの使われ方、リスクの高いユースケース、データガバナンスの確保の仕方などを理解することは極めて重要です。Salesforceの取締役会はAIについて10年近く議論してきましたが、多くの取締役にとってはまったく新しい領域であり、教育が必要となります。

テクノロジーは常に変化していますが、この5年間は、ある一貫した事柄を私に教えてくれました。私たちはこのエキサイティングなテクノロジーを探求し続ける中で、人々が責任を持ってAIを利用できるよう力を与え、AI革命が私たちの社会に及ぼす影響について考えなければなりません。